创智复旦字节发布AgentGym-RL, 昇腾加持, 开创智能体训练新范式

创智复旦字节发布AgentGym-RL, 昇腾加持, 开创智能体训练新范式

更新时间: 浏览次数: 258

机器之心编辑部

强化学习之父、2024 年 ACM 图灵奖得主 Richard Sutton 曾指出,人工智能正在迈入「经验时代」—— 在这个时代,真正的智能不再仅仅依赖大量标注数据的监督学习,而是来源于在真实环境中主动探索、不断积累经验的能力。正如人类通过实践理解世界、优化行为一样,智能体也必须在交互中积累经验、改进策略,才能掌握长期决策的能力。

无独有偶,特斯拉前 AI 负责人,OpenAI 联合创始人 Andrej Karpathy 进一步指出,环境的多样性与真实性,是智能体获得泛化能力、应对复杂任务的关键前提。缺乏丰富的环境,智能体就无法充分暴露于多样化情境,也难以从经验中形成稳健的决策策略。

在这一背景下,复旦、创智、字节的研究者们基于智能体自我进化框架 AgentGym,全新打造了多环境强化学习智能体训练框架 AgentGym-RL。

本文的第一作者为复旦大学自然语言处理实验室博士生奚志恒,通讯作者为复旦大学自然语言处理实验室的桂韬教授和张奇教授。

这一框架是首个无需监督微调、具备统一端到端架构、支持交互式多轮训练,且在多类真实场景中验证有效的 LLM 智能体强化学习框架,为 LLM 智能体的强化学习提供了全新的解决方案。

依托 AgentGym-RL 框架,研究人员创新性地提出了智能体范式下扩展测试时计算的新路径 —— 扩展环境交互(Scaling Interaction)。其核心是通过增加训练与测试阶段模型和外部环境的交互回合数,让模型借助多轮反馈逐步完善决策、提升表现。

相较于传统测试时扩展方法,新路径优势显著:传统方法局限于模型内部,仅靠延长思维链消耗更多 Token,缺乏与外部环境的实时互动,难以应对复杂任务的动态场景需求;而扩展交互轮次突破了这种封闭式推理,允许模型依据每轮反馈动态修正策略,最终以更结构化的决策流程、更高效率的问题解决路径完成任务,成为智能体范式下表现更优的测试时扩展方案。

然而,长交互轮次训练面临着容易出现崩溃的问题。针对这一痛点,研究团队再次突破,提出了 ScalingInter RL 交互轮次扩展策略,通过分阶段增加模型最长交互轮次限制,使智能体能够先在短交互轮次下掌握基础技能,再逐步过渡到中长交互轮次解决复杂任务,平衡了智能体训练过程中的探索与利用,有效规避了模型崩溃的风险,成功构建了稳定的交互轮次扩展训练范式。

借助 AgentGym-RL 这一统一框架,结合 ScalingInter-RL 算法的稳定扩展能力,研究团队取得了令人瞩目的成果:

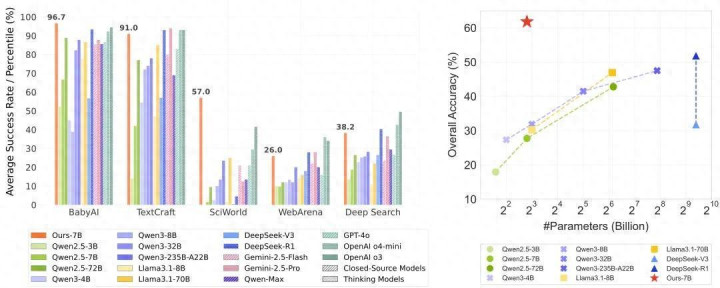

仅仅是 7B 大小的模型,在多个真实任务导向的环境中经过长轮次交互训练后,竟逐步掌握了理解任务目标、预测行动后果、规划多步操作等复杂任务处理技能。从自主浏览界面、精准筛选选项,到对比参数、执行操作,整个过程流畅高效,展现出前所未有的自主决策水平。在五种测试环境、26 项测试任务中,它不仅超越了 100B 以上的大型开源模型,还追平了 OpenAI o3、谷歌 Gemini 2.5 Pro、DeepSeek r1 等顶尖商业模型的水平,充分彰显出 AgentGym-RL 框架与交互轮次扩展范式的强大潜力与竞争力,也为人工智能在 「经验时代」 的发展注入了强劲动力。

商业模型、开源模型以及本文强化学习模型在不同智能体任务中的表现。

从网页导航到科学实验,从文字游戏到实体交互,这套兼容 PPO、GRPO 等主流算法的模块化框架,正为开源社区推开自主智能体研发的全新大门。

论文标题:AgentGym-RL: Training LLM Agents for Long-Horizon Decision Making through Multi-Turn Reinforcement Learning

研究背景:从 「数据密集」 到 「经验密集」

构建能够在复杂现实场景中完成多轮决策的自主 LLM 智能体,是人工智能领域一个新兴且快速发展的前沿方向。

Sutton 曾强调,人工智能的发展正从 「数据密集型」 向 「经验密集型」 转型:早期模型依赖海量标注数据进行监督学习,如同通过教科书间接获取知识;而真正的智能体应当像人类一样,在真实环境中通过 「做中学」积累经验,在持续交互中理解环境规则、预测行动后果、优化长期目标。

而在这一过程中,构建真实、多样、贴合现实需求的交互环境则成为了强化学习的重中之重。真实的环境是智能体获得有效经验的基础,只有还原场景中的动态变化与不确定因素,才能避免智能体陷入 「实验室表现优异、落地即失效」 的困境;环境的多样化是智能体具备泛化能力的前提,只有覆盖多类型任务场景的交互逻辑,才能让智能体在新场景中快速迁移已有经验。

然而, 当前大多数现有研究局限于单轮任务,缺乏与复杂环境的多轮交互机制。虽然最近有研究尝试扩展 RL 以训练具有多轮能力的 LLM 智能体,但这些工作仍然存在任务场景单一、环境适配性差、优化稳定性低等问题,使得智能体无法接触到足够丰富的环境信息,难以生成和利用第一手经验,自然难以应对现实世界复杂多变的任务。因此,该领域目前仍然缺乏一个统一的、端到端的、交互式多轮 RL 框架,能够在广泛的实际场景和环境中有效地从头开始训练 LLM 智能体,而无需依赖监督微调(SFT)作为初步步骤。

为填补这一空白,研究团队提出了 AgentGym-RL,一个通过强化学习训练 LLM 智能体进行多轮交互式决策的新框架。该框架的研究工作围绕着推动智能体高效学习和决策展开,主要有以下贡献:

提出并开源 AgentGym-RL 框架:这是一个全新的、统一的、模块化且灵活的端到端 RL 框架,专为智能体多轮交互式决策而设计,包含丰富多样的场景和环境,让 「从经验学习」 有了标准化的实验场。

引入 ScalingInter-RL 方法:这是一种基于渐进式交互轮数拓展的强化学习训练方法,使智能体能够逐步适应环境,优化其交互模式、行为和技能,最终在探索和利用之间实现更好的平衡。

验证框架和方法的有效性:通过大量实验验证了 AgentGym-RL 和 ScaleInter-RL 能够显著且稳定地提升智能体性能,使其在复杂任务处理能力上与顶尖商业模型形成对标甚至实现性能反超。

AgentGym-RL:为经验时代打造的自主智能体训练基础设施

AgentGym-RL 集成了多种环境、丰富的轨迹数据和全面的基准测试,通过标准化环境操作接口,将复杂的环境配置流程简化为便捷的模块化操作。该框架以 AgentGym 为基础进行迭代升级,通过优化模型与环境的交互协议、强化分布式并行计算架构、引入强化学习训练模块等方式进行改进。

其核心目标,就是为 LLM 智能体构建一个能够持续产生 「有效经验」 的生态,让「经验驱动学习」不再依赖零散的实验设置,而是具备可复现、可扩展的坚实基础。

模块架构

AgentGym-RL 框架主要包含环境、代理和训练三个组件。

环境模块中,每个环境打包为独立服务,支持并行请求,环境客户端通过 HTTP 连接服务器,向代理暴露如获取观测、动作等 API,涵盖多场景、环境、任务和数据实例,为 LLM 代理训练提供支持

代理模块封装语言模型代理与环境的交互逻辑,支持多种提示和采样配置,扩展长期规划、自我反思等高级机制。

训练模块实现支持在线算法的统一强化学习管道,管理经验收集等,支持课程学习和交互扩展,高度模块化,支持多训练方法,训练过程可分布在多节点。

AgentGym-RL 架构图:采用解耦化设计,兼具灵活性与可扩展性,能够支持多种场景、环境类型及算法的应用与适配。

多样化的环境

AgentGym-RL 框架包含多种环境和丰富的任务,涵盖了网页导航、文字游戏、具身控制、科学探索和深度搜索等多个类别 —— 精准对应了语言智能体领域的重要推动者、OpenAI 研究科学家姚顺雨所说的 「AI 下半场落地场景」,每一类环境都指向真实世界中 AI 需要解决的实际问题。该框架支持主流的 RL 算法,并配备了广泛的实际场景:

网页导航:对应 WebArena 等环境,包含电商、Reddit 论坛、GitLab 协作开发、OpenStreetMap 地图、CMS 内容管理系统等 5 个子任务,共 372 个训练查询和 50 个测试查询。智能体需模拟人类与网页交互,完成在线购物、信息提取、表单填写等操作,涉及地图、计算器等工具的使用。

深度搜索:对应基于搜索引擎的环境,涵盖 NQ、TriviaQA、PopQA 等 7 个数据集的任务。智能体需通过动态生成搜索查询、调用浏览器和 Python 解释器等工具,从外部源获取信息并整合,完成多轮检索与推理任务。

电子游戏:对应 TextCraft 等环境,这是一种类 Minecraft 的文本制作游戏。任务按制作树深度分为 1-4 级,智能体需通过自然语言交互使用制作、 inventory 管理等 API,完成从简单到复杂的物品制作任务。

具身控制:对应 BabyAI 等环境,这是一个可控的网格世界,任务按最终目标分为 6 个子集。智能体需通过自然语言指令导航,执行移动、拾取物体、开门等动作,涉及空间推理和环境交互能力。

科学任务:对应 SciWorld 等环境,选取 8 个子任务。智能体需在模拟的科学场景中,使用实验室仪器相关 API 进行实验(如测量温度、连接电路、混合化学物质),完成科学探索和假设验证任务。

多种强化学习算法

AgentGym-RL 提供全面的算法支持,涵盖不同的学习方法,包括监督微调(SFT)、直接偏好优化(DPO)、拒绝采样和在线 RL 算法等。在线 RL 是 AgentGym-RL 的核心,支持多种主流在线 RL 算法,如近端策略优化(PPO)、组近端策略优化(GRPO)、增强型 REINFORCE(REINFORCE++)和基于回合的策略优化(RLOO)等。

ScalingInter-RL:交互扩展新策略

基于 AgentGym-RL 框架,研究团队创新性地提出了 ScalingInter-RL 方法,通过扩展智能体在训练过程中的交互轮数,平衡智能体对环境的探索与利用,显著提升智能体在复杂环境中的学习和决策能力。

ScalingInter-RL 方法的核心在于逐步、动态地扩展智能体与环境的交互轮次。

在训练的初始阶段,智能体的主要任务是快速学习基本技能,解决相对简单的问题。此时,ScalingInter-RL 会限制交互轮次,引导智能体集中精力利用已有的知识和策略,尽可能高效地完成任务。这种策略就像是为智能体制定了一个循序渐进的学习计划,让它在稳固的基础上逐步成长。

随着训练的稳步推进,智能体已经掌握了一定的基础能力,此时 ScalingInter-RL 会适时地增加交互轮次。这一举措鼓励智能体勇敢地探索更多未知的领域,尝试不同的行动和策略。通过这种方式,智能体能够避免陷入固定的思维模式和行动路径,不断优化自己的行为,从而更好地应对复杂多变的环境。

在实际应用中,这种策略展现出了显著的优势。在网页导航任务中,初始阶段,智能体通过有限的交互轮次,迅速掌握了基本的网页操作技能,如点击链接、填写表单等。随着训练的深入,交互轮次的增加使得智能体能够更加深入地探索网页的各种功能和结构,学会了根据不同的任务需求,灵活地调整操作策略,从而更加高效地完成任务。在科学任务中,智能体在初期利用有限的交互学习基本实验操作,随着交互轮次的增多,能够更全面地探索实验条件和变量之间的关系,优化实验步骤,提高实验成功率。

实验

为了全面验证 AgentGym-RL 框架的稳定性和有效性,研究团队开展了一系列广泛且深入的实验。这些实验覆盖了丰富多样的场景和环境,旨在模拟智能体在实际应用中可能面临的各种复杂情况,从而全面、准确地评估智能体的性能。

实验涵盖了五个主要场景,包括网页导航、深度搜索、数字游戏、具身任务和科学任务。

主要结果

在 5 个不同场景(Web 导航、深度搜索、数字游戏、具身任务、科学任务)中,使用 AgentGym-RL 框架训练的开源模型展现出了出色的多轮交互决策能力。

进一步,通过 ScalingInter-RL 方法的优化,这些模型实现了显著的性能提升,甚至超越了一些大型商业闭源模型。在网页导航任务中,ScalingInter-7B 模型的总体准确率达到了 26.00%,大幅超越了 GPT-4o 的 16.00%,与 DeepSeek-R1-0528 和 Gemini-2.5-Pro 的表现相当;在科学场景中,ScalingInter-7B 模型以 57.00% 的总体得分创下新的最优成绩,远超所有开源和专有模型,包括排名第二的专有模型 OpenAI o3(41.50%)。

因篇幅所限,此处仅展示部分实验结果,更多详细结果请查阅论文。实验结果表明,经 ScalingInter-RL 算法训练的模型在多个环境中均达到了领先水平,实现了显著的性能提升。

在 WebArena 环境下的实验结果。

在 SciWorld 环境下的实验结果。

ScalingInter-RL 展现更稳定高效的强化学习优化动态

ScalingInter-RL 方法在训练稳定性与效率上显著优于传统方案。实验表明,训练周期内,采用该方法的智能体奖励值始终保持上升趋势,而固定轮次模型 150 步后奖励值衰减 32%。这种稳定性源于其渐进式交互设计 —— 通过动态调整交互深度,使智能体在技能积累阶段避免因探索过度导致的策略震荡,在优化阶段又能保持足够的行为多样性。

效率方面,ScalingInter-RL 方法同样提升显著。TextCraft 任务中,ScalingInter-RL 以传统方法 60% 步数达成 89% 成功率;WebArena 导航任务里,单位计算量性能增益是 PPO 算法 1.8 倍,适合大规模多场景训练。

ScalingInter-RL和传统RL算法的训练动态对比

后训练与测试时计算量比模型规模具有更高的缩放潜力

实验得出一个关键见解:有策略地投入后训练计算和测试时计算,比仅仅增加模型的参数数量更具影响力。7B 参数的 ScalingInter-RL 模型在经过本文研究者的强化学习框架训练后,不仅超过了其他同等规模的开源模型,还显著优于参数规模近其十倍的更大模型。

这表明,针对性的训练与推理计算投资,比单纯扩大模型参数更具性价比。

本文框架和方法通过后训练,显著提升了7B参数规模开源模型的能力,不仅超过了其他同等规模的开源模型,且显著优于参数规模近其十倍的更大模型。

环境结构是决定强化学习效率的关键因素

不同场景的结构特性对 RL 训练效果产生显著分化影响。在规则明确、反馈清晰的环境(如 TextCraft、BabyAI、SciWorld)中,RL 能带来大幅性能提升;而在开放式环境(如 WebArena、SearchQA)中,性能提升则有限。

这表明,环境的规则明确性、状态可观测性和奖励稀疏度,共同构成了 RL 算法效率的边界条件 —— 当环境复杂度超出智能体的状态表征能力时,即使最优训练策略也难以发挥作用。

讨论

研究团队从三个角度调查了智能体表现如何随推理时计算增加:

扩展交互轮次:随着推理时交互轮次的增加,所有模型的性能均呈现上升趋势,其中经 AgentGym-RL 训练的智能体始终保持领先优势,验证了交互扩展对环境探索的重要性。

随着测试时交互轮次的增加,所有模型的性能均呈现上升趋势。

扩展采样数量:在并行采样方面,增加采样数量(K 值)能显著提升 Pass@K 指标,且经 RL 训练的模型在相同采样预算下表现更优。

随着采样数量的增加,所有模型的性能均呈上升趋势。

不同 RL 算法比较:对比 GRPO 与 REINFORCE++ 两种主流 RL 算法发现,GRPO 在 TextCraft、BabyAI 和 SearchQA 任务上均显著优于 REINFORCE++。即使 3B 参数的 GRPO 模型,其性能也超过 7B 参数的 REINFORCE++ 模型,表明算法选择对性能的影响可能大于模型规模。

模型在不同强化学习算法下的测试结果

真实交互示例

不妨聚焦这些真实交互场景 —— 在以 BabyAI 为代表的具身任务中,该研究中的智能体展现出了卓越性能。以 「找到黄色小球并带回起点」 这一任务为例,其不仅要求智能体具备基础的路径规划与避障能力,还涉及更为复杂的长程依赖与顺序规划逻辑。跨步骤的信息利用能力、动态化的探索策略,以及对多阶段任务的全局把控能力,使得该任务的难度远超单一反应类操作。

而基于 AgentGym-RL 框架、经 ScalingInter 算法训练的智能体,正是在这类高难度场景中展现出了令人瞩目的表现。它不仅能精准理解任务核心目标,还能在多扇彩色门与未知房间构成的复杂环境中,开展有条理的探索活动,合理规划行动顺序;当确认某一区域无探索价值后,更能主动离开并转向新的探索路径。尤为难得的是,它能高效利用已获取的环境信息,将分散在不同时间节点的观察结果串联起来,构建连贯的决策链路。正是这种跨步骤的信息整合能力与动态调整机制,让它在复杂环境中始终保持清晰且高效的任务执行能力。

而在以 WebArena 环境为代表的真实网页交互场景中,智能体需要面对充斥着大量噪音的网页界面,真正的功能入口往往被隐藏在层层标签页和复杂的交互逻辑之下。若缺乏对页面结构的理解,智能体很容易陷入低效的穷举式搜索。然而,基于 AgentGym-RL 框架、经 ScalingInter 算法训练后,智能体能够主动点击 「Sales」 标签页,精准锁定与任务相关的入口,并进一步利用内置的 「Filter」 功能进行筛选,而不是依赖低效的遍历查看。这一系列操作表明它已经掌握了网页的结构与规则,并能基于探索经验选择更高效的策略,从而显著提升任务的准确性与执行效率。

视频链接:

https://mp.weixin.qq.com/s/_s1c2uj8B9u-i7wgoM2gwA

结论与展望:以经验学习开启 AI 下半场的自主智能体时代

AgentGym-RL 框架的推出,不仅是自主 LLM 智能体训练领域的一次技术突破,更标志着 AI 行业向「经验时代」的深度迈进。

从技术层面看,AgentGym-RL 通过统一的端到端 RL 框架,解决了自主智能体训练中 「场景单一、算法割裂、效率低下」 的痛点,让 「从经验中学习」 成为标准化、可复现的技术路径;而 ScalingInter-RL 方法则通过渐进式交互轮次扩展,平衡了经验探索与利用的关系,让智能体能够像人类一样 「循序渐进积累能力」。实验数据充分证明了这一方案的价值:7B 参数的开源模型在 26 项任务中对标甚至超越顶级闭源模型,为 AI 下半场的技术发展提供了新范式。

然而,探索的道路永无止境。未来,本文研究者们将重点关注以下三个方向:

1. 通用能力升级:使智能体打破 「领域壁垒」,在全新环境和面对未知工具时仍能进行高效决策;

2. 复杂场景拓展:向更长周期、更贴近物理世界的任务拓展,例如机器人操作、现实场景规划等,以应对更丰富的感官输入和庞大的行动空间;

3. 多智能体协同:从 「单打独斗」 转向 「团队协作」,探索多智能体系统的训练模式,以解锁更复杂的群体决策能力。

AgentGym-RL 框架已全面开源,期待与全球研究者携手,共同推动下一代智能体的发展,让人工智能在现实世界中展现出更卓越的 「行动力」!

本研究得到了华为昇腾 AI 处理器的算力支持。在昇腾和开源社区的努力下,诸多大模型训练框架均已支持昇腾 AI 处理器。此外,昇腾联合 vllm 社区推出了 vllm-ascend 框架,极大提升了百亿乃至千亿级参数量的大模型在国产算力上的推理效率。在本研究中,昇腾 910B NPU 在多个实验阶段中发挥作用 ,提高了研究效率。

美国关键就业数据突然“爆雷”!金价惊现32美元“巨震”行情 接下来如何交易热点栏目自选股数据中心行情中心资金流向模拟交易客户端 文章来源:24K99 周四(9月11日)纽约交易时段,受美国CPI和初请失业金人数数据影响,黄金价格出现剧烈波动,金价在大跌后急剧反弹,缩减日内多数跌幅,最终当日收盘小幅走低

推荐阅读

台作家:盼有生之年看到祖国统一

746

746

北京市违法和不良信息举报电话已变更

332

332

花间一梦

2025-09-12 13:46:51

553

553

553

553

匈牙利总理抵达基辅将会见泽连斯基

201

201

罗晋杨子姗大赞泉州风景好人情味足

26

26

神偷奶爸4小黄人换新老大

735

735

初中男生被霸凌致下体烧伤 警方介入

24

24

新华社评农村学生营养餐补贴被挪用

854

854

斯里兰卡4渔民喝漂流瓶中液体死亡

20

20

电视剧执行法官口碑

271

271